Franck Régnier-Pécastaing est responsable des offres Data (EIM, MDM, DQM, Semantic) chez Logica Management Consulting depuis 2005.

in Data Veritas : Franck Régnier, vous êtes co-auteur d’un livre intitulé « MDM : Enjeux et méthodes de la gestion des données ». Quelles sont les principales idées soutenues dans cet ouvrage?

Franck Régnier

Franck Régnier-Pécastaing est responsable des offres Data (EIM, MDM, DQM, Semantic) chez Logica Management Consulting depuis 2005.

in Data Veritas : Franck Régnier, vous êtes co-auteur d’un livre intitulé « MDM : Enjeux et méthodes de la gestion des données ». Quelles sont les principales idées soutenues dans cet ouvrage?

Franck Régnier : L’idée principale est que le MDM est avant tout une démarche, que celle-ci doit-être gouvernée et pilotée. Ainsi la solution technologique n’est qu’une des composantes de la réussite d’une telle initiative et elle doit répondre à un besoin et des objectifs mesurables et priorisés. Sans dévoiler tous les secrets de Logica Management Consulting sur le MDM et le DQM, les notions d’enjeux, d’architectures et de gouvernance ont été traitées avec attention.

iDV : Ce livre fait l’objet d’attentes importantes de la communauté des éditeurs de logiciels. Pouvez-vous nous dire pourquoi ?

Franck Régnier :

Je ne sais pas si les éditeurs attendent vraiment. Mais ce livre est le premier en français sur le sujet. Il a été écrit pour les non spécialistes afin de vulgariser les thèmes du MDM et de la Gouvernance des données. Nous espérons ainsi permettre un gain en maturité du marché, bénéfique pour l’ensemble des intervenants, les éditeurs, mais aussi nos confrères et compétiteurs.

Le marché du MDM, du DQM, de la gouvernance des données ne deviendra vraiment significatif que si les acteurs et les clients sortent d’une approche technico-technique du sujet et s’emparent d’enjeux métiers majeurs, notamment dans un contexte de crise. Je pense au multi-canal et aux stratégies centrées sur le client, je pense à l’amélioration du Time to Market par une meilleure maitrise de son référencement produit ou de sa logistique, etc… Tout ceci repose sur des référentiels, une donnée de qualité et une approche pilotée des priorités.

iDV : Franck Régnier, vous êtes porteur des offres Data (Master Data Management, Data Quality Management, Semantic) chez Logica Management Consulting. Quel est l’intérêt spécifique pour Logica de contribuer à ce livre ?

Franck Régnier : Tout d’abord ce livre n’est pas qu’un pur produit Logica. Il a été écrit avec les collaborateurs d’un de nos clients, EDF. Les co-auteurs en sont Michel Gabassi et Jacques Finet. Et nous avons travaillé avec un éditeur reconnu pour son sérieux, DUNOD.

Le marché est en pleine phase d’accélération alors que les sources d’information restent peu nombreuses. Les quelques publications françaises en la matière reste l’apanage de quelques éditeurs hexagonaux sous forme de livre blanc ou encore la citation du MDM comme brique constitutive de la SOA au sein d’ouvrages comme ceux de Pierre Bonnet ou de Francois Rivard, Georges Abou Harb et Philippe Meret.

Cette relative pauvreté d’information, notre vision alliant autant l’organisation, la gouvernance et la technologie dans la réussite d’une démarche orientée Donnée, le besoin d’un état des lieux permettant à nos interlocuteurs d’appréhender plus facilement chacune de ces dimensions sont autant de raisons qui ont poussé Logica à vouloir établir une synthèse sur le sujet tout en le rendant accessible.

La deuxième raison, plus mercantile, est que Logica possède de nombreux atouts en matière de MDM et de DQM. Nous sommes en position de leader, mais nous ne sommes pas seuls et de nombreux acteurs interviennent sur le marché avec de sérieuses prétentions. Ce livre est ainsi le vecteur permettant d’afficher une approche que nous jugeons unique sur le marché.

La troisième raison est que le Groupe Logica a fait des offres SOA un de ses vecteurs de croissances majeures dans sa stratégie. Logica est le premier cabinet et intégrateur SOA en France (source PAC). Le MDM, en répondant à la dimension Data de la SOA, entre dans cette stratégie. Le soutien à ce livre par Logica a donc été naturel et j’en remercie ma hiérarchie.

iDV : Le livre s’intitule « MDM » mais vos réponses semblent indiquer que les sujets dont vous traitez sont plus larges ?

Oui et non. Si j’utilise le trigramme MDM, on pense directement à l’outillage des référentiels et dans ce cadre je considère que notre discipline est à l’étroit. Si je prends la définition réelle des mots Master Data Management, c’est bien de gestion de données dont il s’agit et cette gestion invoque de multiples disciplines comme le DQM ou la Gouvernance des données.

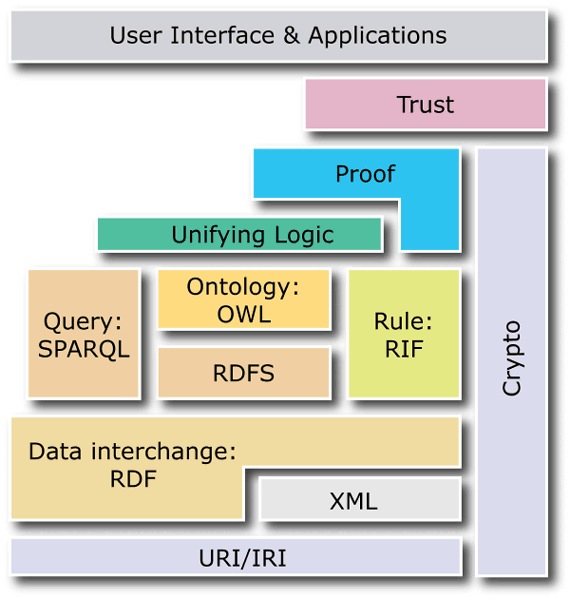

Demain ce sont la gestion d’identité complexe et la gestion de la fraude qui reposeront sur ces disciplines. Ce sont aussi l’extension de la démarche aux données non structurées (ECM, …) ainsi que la maitrise des technologies sémantiques (ontologies, …) qui ouvriront la voie vers l’EIM (Enterprise Information Management). Le MDM n’est qu’une étape pour une meilleure gestion de l’information de l’entreprise.

Et votre blog, Olivier, est bien la preuve que nous devons étendre notre champ d’expertise pour répondre aux enjeux de nos clients.

En conclusion

Disponible depuis novembre 2008, le livre "MDM : Enjeux et méthodes de la gestion des données", s'annonce comme un ouvrage de référence du MDM et de la gestion maîtrisée des données.

Propos recueillis par Olivier Mathurin, pour le blog In Data Veritas.